Pour faire suite au premier article programmatique de cette minisérie dédiée aux métadonnées optiques, nous vous proposons une plongée détaillée dans ces quelques journées consacrées à la mise en évidence des métadonnées optiques.

Dans de nombreux cas de production classique, il nous semble évident que la présence de métadonnées optiques associées aux rushes permettrait une approche plus efficace de la post-production, pour les corrections de déformation et de vignettage, pour stabiliser un plan, pour faciliter l’intégration de plates dans le cas des fonds verts et bleus… Dans le cas de la production virtuelle, les métadonnées optiques sont une nécessité !

C’est d’ailleurs sans doute l’avènement de la production virtuelle qui a poussé plusieurs fabricants a accélérer le développement des métadonnées optiques. Et pas seulement les fabricants d’optiques ! Car les méta passent par les cameras et autres accessoires. Nous avons donc mis a profit notre réseau de partenaires UCO pour pouvoir traiter ce sujet tentaculaire. Merci à Cooke, Zeiss, Arri, Sony, et Blackmagic et tous les loueurs qui nous ont accueilli pour ce défi.

Pour la première session de mise en œuvre de notre étude, chez PhotoCineRent, nous mettons à l’épreuve le protocole qui nous a semblé pertinent. Il s’agit là d’un protocole un peu expérimental, dans le sens où il n’existe à notre connaissance pas de précédent, comme cela peut être le cas pour les comparaisons de rendus visuels des optiques où la façon dont les capteurs numériques gèrent les hautes et basses lumière. En effet, notre étude des métadonnées optiques se borne à considérer les capacités et le flux de transmission de données des optiques et non leurs qualités et spécificités esthétiques. Un exercice nouveau pour nous !

Un protocole

Nous nous sommes évidemment intéressé à la manière de transmettre les métadonnées issues de la prise de vues à nos collègues de post-production.

Par l’intermédiaire de la CST, que nous associons à nos travaux, nous nous sommes rapprochés de la Compagnie Générale des Effets Visuels (merci à Françoise Noyon, à Pierre Billet et Vanessa Lafaille), pour qu’ils partagent leurs expériences sur l’objet de notre étude et pour établir un protocole viable, c’est à dire qui corresponde à des cas pratiques concrets.

Nous partons du présupposé que chaque plan doit en théorie comporter 7 points de track à chaque image. Ce nombre est un minimum nécessaire pour permettre le calcul de la position dans l’espace de caméra virtuelle reconstituée grâce au tracking 3D. Nous fabriquons donc des cibles de track pour imposer ce minimum.

Concernant les focales fixes, au sein des séries, il ne nous apparaît pas nécessaire de monter toutes les optiques, mais plutôt une ou deux courtes, plus sujettes aux déformations, et un 32mm, un ou 35mm ou un 50mm de référence (selon la série optique et la taille du capteur). Concernant les zooms, priorité sera donnée aux zooms courts (en supposant que les zooms longs de la série ont les mêmes spécificités électronique que les zooms courts).

Chaque configuration donnant lieu à une prise de vue doit être répertoriée, de façon à pouvoir comparer nos notes sur le terrain et les métadonnées effectivement enregistrées. Mais aussi où elles sont enregistrées (intégrées aux fichiers image, dans des fichiers tiers, voire des fichiers de log hors caméra), comment elles sont extraites et par quel logiciel elles peuvent être exploitées.

La disposition des trackers devra idéalement faire l’objet d’une empreinte 3D avec une référence d’échelle. Cela peut se faire simplement via un iPhone (à partir de l’iPhone 12 pro) ou un iPad récents via une application de photogramétrie.

Avec un déroulé indicatif qui doit mettre en évidence la pertinence de l’exploitation des métadonnées optiques, nous savons aussi que nous devrons nous adapter au matériel réellement disponible le jour des prises de vues chez nos partenaires.

Nous partons sur les cas suivants :

– 1. Bascule de point sur pied : exécuter une bascule de point entre deux marqueurs éloignés, une version rapide (2s) et une version lente (10s), afin de tester la dynamique d’échantillonnage.

– 2. Changement de focale (pour les zooms) sur pied : exécuter une bascule de focale entre deux marqueurs éloignés, une version rapide (2s) et une version lente (10s), afin de tester la dynamique d’échantillonnage.

– 3. Bascule de diaph sur pied: exécuter une bascule de diaph, une version rapide (2s) et une version lente (10s), afin de tester la dynamique d’échantillonnage.

– 4. Suivi de point en camera portée : exécuter un plan porté avec déplacement latéral pour créer une parallaxe. Combiner avec un mouvement panoramique pour cadrer tous les marqueurs. Le pointeur se calera sur la profondeur de la rangée médiane.

– 5. Changement de focale (zoom) plus suivi de point en camera portée : exécuter un plan porté avec déplacement latéral pour créer un parallaxe et changement de focales. Combiner avec un mouvement panoramique pour cadrer tous les marqueurs. Le pointeur se calera sur la profondeur de la rangée médiane.

LDS, /i et eXtended

Ces trois dénominations désignent toutes des technologies de métadonnées optiques :

– LDS est le nom du Lens Data System conçu par Arri

– /i est le protocole conçu par Cooke

– eXtended Data, dérivé du système /i est le protocole développé par Zeiss

Concrètement, les 3 systèmes permettent d’extraire des données clés utiles à la post-production, et par extension aux VFX. Certaines de ces données sont lisibles facilement dans des logiciels de post-production de montage ou d’étalonnage, d’autres sont plus spécifiques et moins accessibles.

Les données de base sont :

– Nom, type et longueur focale de l’optique utilisée

– Distance de mise au point

– Ouverture du diaphragme

– Profondeur de champs

– Distance hyperfocale

Le protocole /i2 (i square ) ajoute des métadonnées gyroscopiques et /i3 (i cube ) des métadonnées de shading et de déformation (jusqu’à 285 i/s).

Le protocole eXtended Data ajoute les données de déformation ainsi que les données de shading précisément basées sur l’ouverture du diaphragme et la distance de mise au point.

Le LDS-2 est annoncé avec un débit de données plus élevé que le LDS-1, ce qui permet une grande précision à des cadences de prises de vues élevées (pour les ralentis par exemple). Par ailleurs, Arri ouvre l’utilisation du protocole LDS-2 à d’autres fabricants.

Caméras, Optiques et boîtiers spécialisés

Concernant les choix de corps caméra et d’optiques, nous nous sommes efforcés de déterminer des configurations classiques de tournage, l’idée étant d’intégrer des optiques modernes équipées de métadonnées ainsi que des optiques anciennes.

Pour notre premier atelier, ce 23 février 2023, nous avons à disposition une Sony Venice 2, une Arri Alexa 35 et même une Phantom Flex. Côté optiques ce sera Zeiss Supreme Prime, Cooke SF+FF et Zeiss Compact Zooms.

Ainsi que deux boîtiers indispensables: un Arri UMC-4 (Universal Motor Controller) et l’ACN-LP Lockit+ de la marque Ambient.

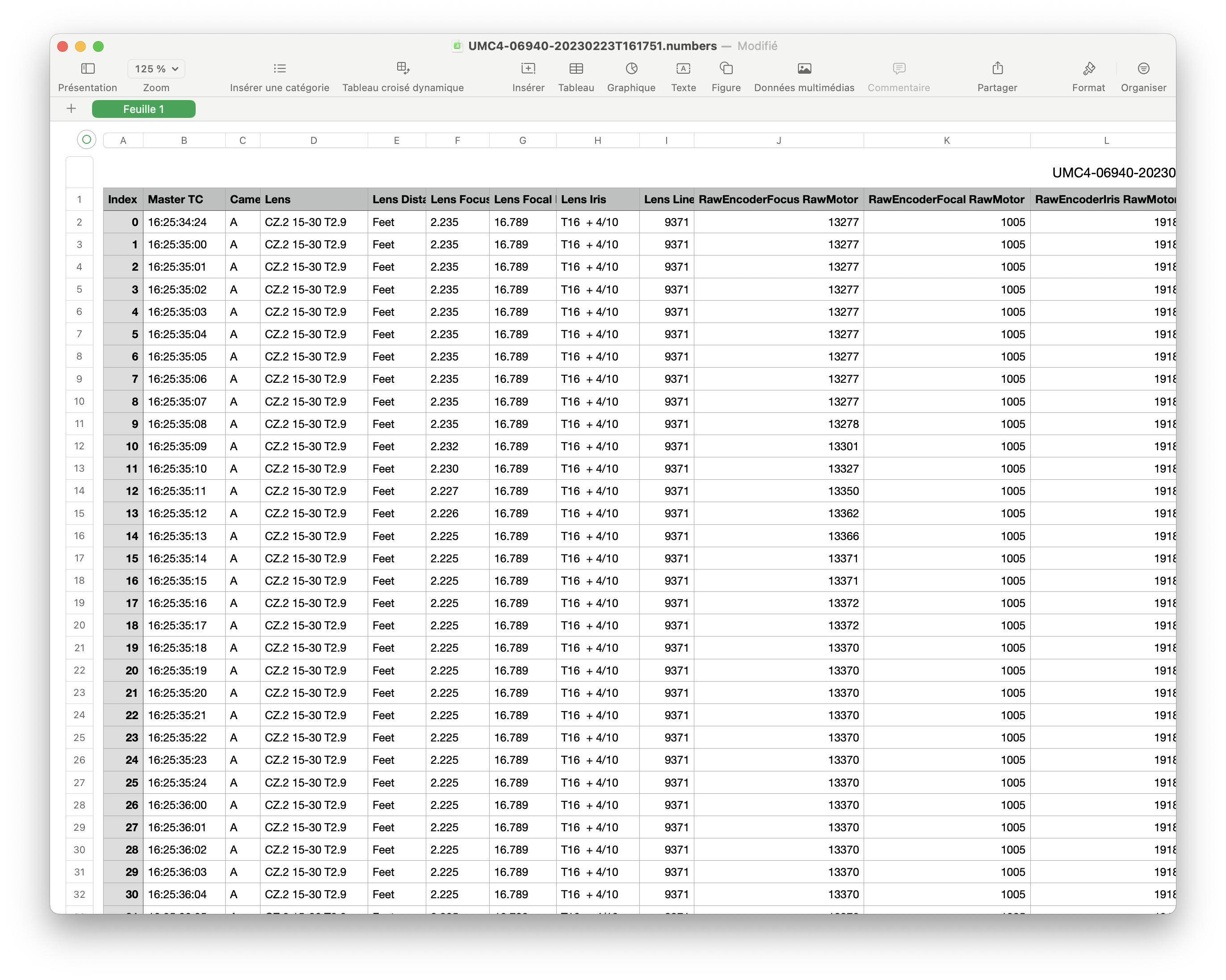

Le boîtier Arri UMC-4 permet de récupérer des métadonnées via la connexion avec les moteurs FIZ (Focus, Iris, Zoom) et de les enregistrer sur une carte SD. Pour interpréter correctement les métadonnées qu’il reçoit, il faut charger dans l’UMC-4 une LDA (Lens Data Archive), un fichier permettant à chaque optique répertoriée (par marque, modèle, focale) d’être reconnue par le boîtier, de sorte que les métas envoyées par l’optique sont bien identifiées et écrites au bon endroit du fichier qui servira en post-production.

Le Lockit+ est chargé à la fois d’alimenter en timecode la caméra (ainsi que le boîtier UMC-4), mais aussi de récupérer les métadonnées directement depuis l’optique si celle-ci est équipée d’un câble Lemo (c’est le cas des optiques /i et eXtended).

Il faut rappeler ici que selon les marques et les modèles, les métadonnées optiques passent soit par les contacts de la monture soit par une prise Lemo spécifique, parfois des deux façons. Il faudrait cependant déterminer si les mêmes informations passent par la monture et par la prise Lemo – sachant que dans le cas de la monture les informations sont destinées à être intégrées aux métadonnées des fichiers image, et dans le cas du Lemo, les informations sont destinées à des dispositifs hors corps caméra).

Le boîtier UMC-4 est bien connu des assistants caméra, qui utilisent les données optiques comme assistance pour le travail du point : grâce aux LDA peuvent être affichées grâce à un dispositif dédié les profondeurs de champs calculés grâce à la focale, l’ouverture et le focus point d’une optique donnée.

L’ACN LP Lockit+ permet d’une part de récupérer les métadonnées des objectifs mais aussi de lier ces données au timecode. Donc de pouvoir enregistrer quelles réglages sur l’optique sont effectués à quel moment, sur toute la durée du plan enregistré. Ce qui permet de disposer des données physiques matérielles qui ont servi à réaliser tel ou tel plan. À peu près une mine d’or pour la post-production et les VFX.

Petite précision tout de même, le Lockit+ intègre dans sa dernière version uniquement l’enregistrement des métadonnées étendues /i3 de chez Cooke. Il était question d’une compatibilité Zeiss dans le futur mais sans certitude à ce jour. Merci au passage à Yannic Hieber qui a bien voulu nous confier un prototype pour nos travaux.

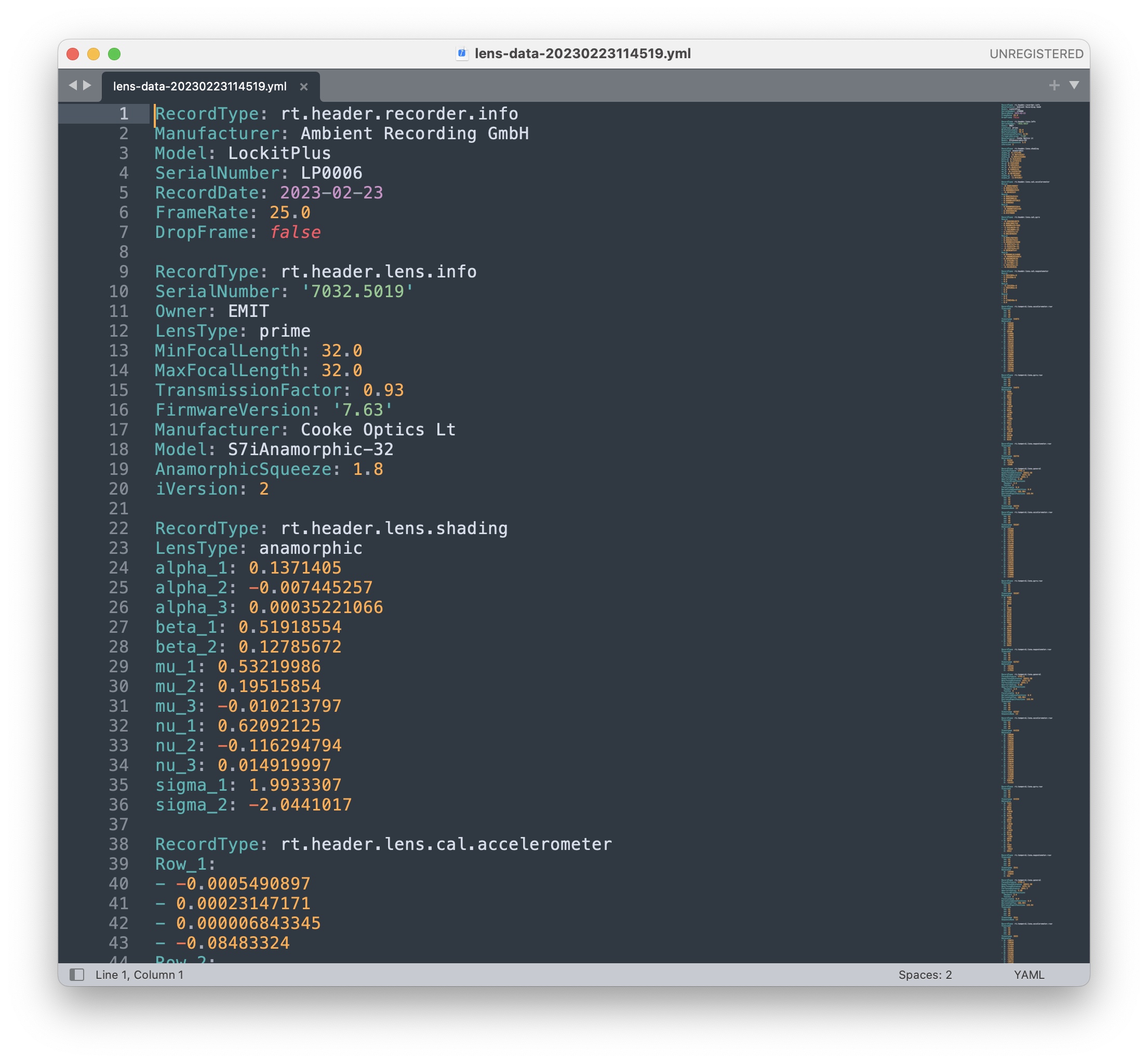

Cela nous a permis d’enregistrer les données brutes des optiques Cooke avec un timecode synchronisé sur carte SD au format YAML. Pour les configurations Zeiss, le boîtier ne faisait qu’injecter le timecode dans la camera et le clap électronique dans le champ. Il fallait compter sur la capacité des cameras à enregistrer les métadonnées par la monture PL.

Les enjeux pour nous sont de plusieurs ordres :

– Trouver comment enregistrer les métadonnées générées par les optiques selon une caméra et une série d’optiques données: est-ce que ces données sont inclues dans les fichiers images ou dans d’autres fichiers générés par les caméras? Est-ce que ces données doivent/peuvent être récupérées par des boîtiers tiers ?

– Pouvoir identifier de quels matériels nous avons besoin pour enregistrer ces données: boîtiers, câbles, montures… Et si nos loueurs français sont en mesure de pouvoir nous les fournir !

– Déterminer quels logiciels peuvent afficher les données enregistrées et les exploiter.

– Affirmer la nécessité d’un dialogue technique entre le tournage et la post-production pour que les métadonnées générées au tournage ne se perdent pas au cours de la post-production, sachant que ces métadonnées intéressent a priori peu le montage mais sont très utiles pour les VFX.

Rappelons que nous nous focalisons sur les conditions de tournages hors studio virtuel.

Premiers contacts

Nous branchons d’abord une Venice 2 équipée d’un 32mm de la série Cooke SF-FF, avec les réglages suivants : X-OCN XT, 8.6K – 3:2 avec 1.8x anamorphose de-Squeeze, obturateur à 90.0°, project frame rate @25fps.

Nous choisissons un obturateur à 90° pour éviter un flou de mouvement trop important. Cette vitesse d’obturation est souvent préconisée pour faciliter le travail d’intégration des VFX sur fond vert/bleu, le motion blur étant ajouté par la suite pour que le rendu de mouvement soit plus naturel à l’œil.

Le plateau et la disposition des trackers par rapport à la caméra sont mesurés à la main et aussi scannés en 3D avec un logiciel de photogramétrie (là Polycam, sur iPad ou iPhone), l’idée est de s’assurer que les distances enregistrées par les métadonnées sont conformes aux mesures de distance réelles.

Un objet rond est positionné en périphérie pour déterminer si déformation il y a et potentiellement calculer un coefficient de déformation précis.

On branche le Lockit+, le câble rouge envoie du TC vers la cam, le câble bleu récupère les données optiques envoyées par l’optique.

Une fois notre ordinateur connecté via wifi au boîtier Lockit+, les données s’affichent et nous pouvons donc enregistrer chaque prise et toutes les métadonnées transmises par l’optique. Les données enregistrées par le boîtier dans un fichier text sont au format YAML (entre XML et CSV), décodables universellement (open source) mais ce sont des données brutes. Il nous faudra par la suite trouver le logiciel qui peut décoder ces données et les fusionner avec les métadonnées d’un fichier image, sur la base du timecode notamment et des données classiques décrivant le plan (nom, date, numéro de bande etc).

Nous passons ensuite un Zeiss Supreme Prime 15mm en adaptant les réglages caméra, puisque nosu passons en sphérique. En revanche nous conservons l’obturateur à 90°.

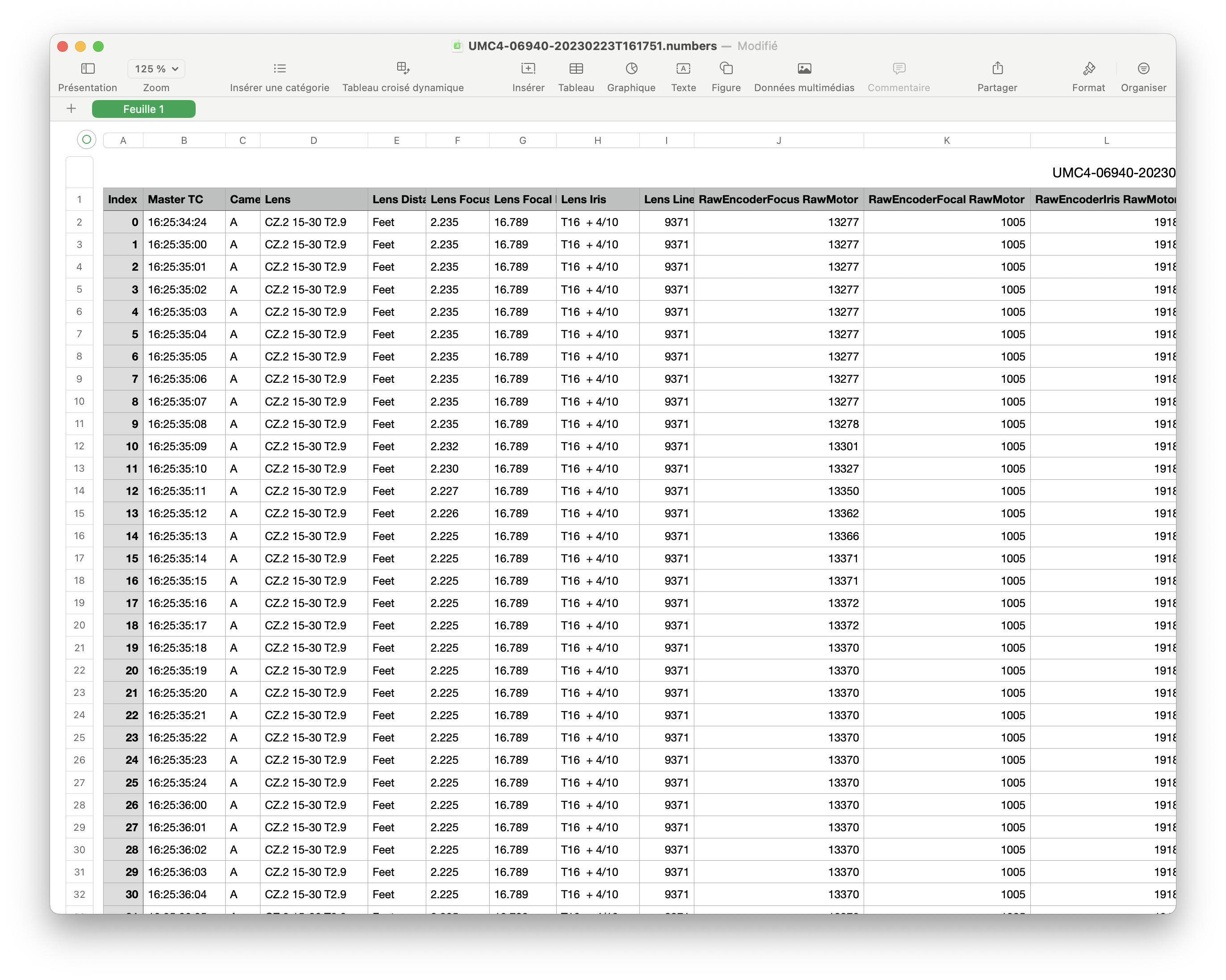

Nous chargeons la LDA dans le boîtier UMC-4 et enregistrons les métadonnées issues des moteurs, à comparer avec les métadonnées enregistrées via le boîtier Lockit+.

Notons qu’avec la Venice 2, il nous faut déclencher manuellement l’enregistrement sur le boîtier UMC-4.

Pour avoir un premier aperçu du fruit de nos efforts, nous comparons avec un même rush issu de la Venice les métadonnées effectivement enregistrées.

Avec Raw Viewer, le logiciel de Sony, nous pouvons visualiser le type de l’optique, le capteur, le diaph ainsi que la distance de mise au point en mètres, mais il s’agit d’un point fixe (au tout début du plan?), sans données dynamiques (donc sans évolutions dans la durée du plan).

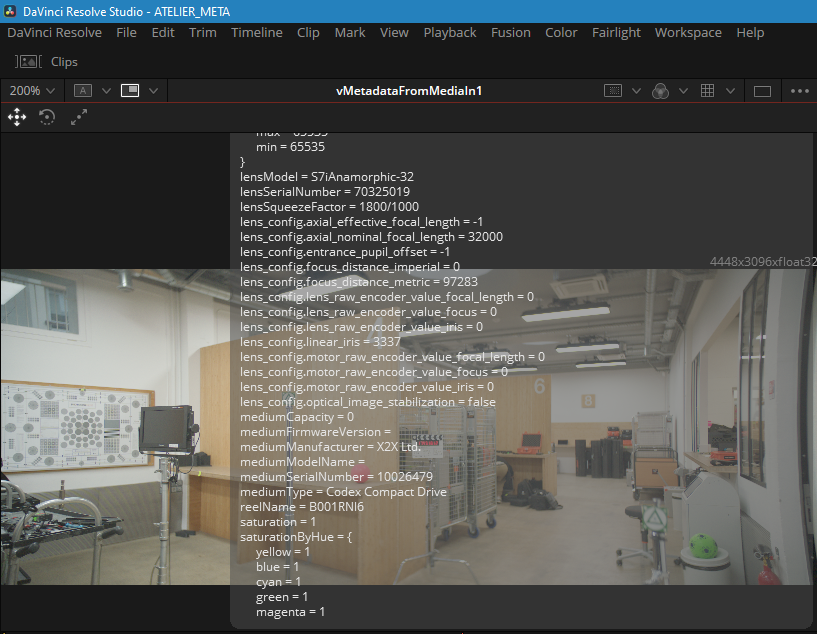

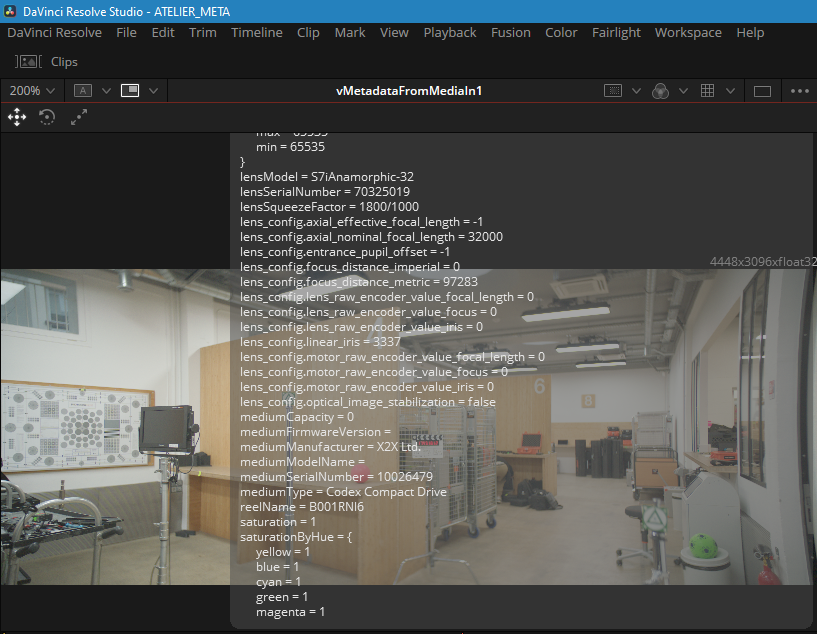

Dans Da Vinci Resolve, il faut creuser un peu plus !

Avec le boîtier Lockit+, les colonnes sont ainsi libellées: Lens general, Lens shading, Gyro, Focus distance, Hyper focal, Min distance, Max distance.

Selon le type de focale, on pourrait ajouter également les données de vignettage et de déformation)

Nous passons ensuite un Compact Zoom Zeiss 15-30mm, pour ajouter des données dynamiques aux valeurs de focales, qui s’affichent comme les autres valeurs en temps réel sur le boîtier Lockit+. Le Lockit n’est pas compatible avec Zeiss.

Nous décidons ensuite de passer sur Alexa Mini LF (enregistrement en 4.5K) avec le 32mm Cooke SF+FF, puis le 50mm Zeiss Supreme Prime. Les données passent toujours par le câble Lemo relié au boîtier Lockit+.

Le passage sur Arri a pour conséquence que l’enregistrement des données sur la carte SD du boîtier UMC-4 se lance automatiquement dès que l’enregistrement est lancé sur la Mini LF (trigger). C’est une bonne surprise car c’est nettement plus confortable.

Pour terminer la journée et parce que la caméra est devant nous, nous chaussons le 32mm Cooke SF+FF sur la Phantom Flex. La caméra est assez rudimentaire et surtout un problème va se poser rapidement : comment injecter un timecode sur une base temporelle de 1000 images pas secondes ? Et quel intérêt d’écrire des données FIZ sur une carte SD si aucun timecode ne synchronise la caméra simultanément au boîtier UMC-4 ?

Sans doute y aurait-il matière à des tests supplémentaires, mais ce serait un autre chapitre, vraiment trop spécifique par rapport à l’objet de notre travail en cours.

Dans un prochain article, nous verrons notamment comment des MDO peuvent être générées avec l’utilisation d’optiques qui en sont dépourvues. À suivre !

Merci à Valentine Lequet coprésidente de l’Union, Sara Cornu, Larry Rochefort et Teddy Ajolet, assistant caméra. Un grand merci à toute l’équipe de PhotoCinrent pour leur accueil et leur implication.

Merci également à Françoise Noyon, Yannic Hieber, Vanessa Lafaille et Pierre Billet.

____

🇬🇧 English version

Following on the first programmatic article in this miniseries dedicated to optical metadata, we’d like to take you on a detailed dive into those few days dedicated to harvesting optical metadata.

In many cases of conventional production, it seems obvious to us that the presence of optical metadata associated with dailies would enable a more efficient approach to post-production, for corrections to distortion and vignetting, to stabilize a shot, to facilitate the integration of plates in the case of green and blue backgrounds… When in the case of virtual production, optical metadata is a necessity !

It is undoubtedly the advent of virtual production that has prompted several manufacturers to speed up the development of optical metadata. And not only lens manufacturers are concerned ! After all, metadata goes through cameras and other accessories. So we’ve taken advantage of our network of UCO partners to tackle this sprawling subject. Thank you to Cooke, Zeiss, Arri, Sony, Blackmagic and all the rental companies that welcomed us for this challenge.

For the first session of our study, at PhotoCineRent, we’re putting to the test the protocol that seemed relevant to us. This is a somewhat experimental protocol, in the sense that to our knowledge there is no precedent for it, as it may be the case for comparisons of the visual rendering of optics or the way digital sensors handle high and low light.

In fact, our study about optical metadata is limited to considering the capabilities and data transmission flow of optics, and not their aesthetic qualities and specificities. A kind of new exercise for us !

A protocol

Of course, we were also interested in how to transmit metadata from the shoot to our post-production colleagues.

We approached the Compagnie Générale des Effets Visuels (thanks to Françoise Noyon, Pierre Billet and Vanessa Lafaille), through the intermediary of the CST, which we associate with our work, so that they could share their experience on the subject of our study and establish a viable protocol, i.e. one that corresponds to concrete practical cases.

We start from the presupposition that, in theory, each shot should have 7 track points in every image. This is the minimum number needed to calculate the position in space of the virtual camera reconstructed using 3D tracking. We therefore manufacture track targets to impose this minimum.

As regards fixed focal lengths, we don’t think it’s necessary to fit all the lenses in the series, but rather one or two short ones, which are more prone to distortion, and a 32mm, 35mm or 50mm reference lens (depending on the optical series and sensor size). As far as zooms are concerned, priority will be given to short zooms (assuming that the long zooms in the series have the same electronic specificities as the short zooms).

Each configuration giving rise to a shot must be listed, so that we can compare our notes in the field with the metadata actually recorded. We also need to know where the metadata is recorded (embedded into the image files, in third-party files or even off-camera log files), how it is extracted and what software is used to process it.

The layout of the trackers should ideally be 3D scanned with a scale reference. This can be done simply using an iPhone (from iPhone 12 pro upwards) or a recent iPad via a photogrammetry application.

With an indicative schedule that should highlight the relevance of using optical metadata, we also know that we will have to adapt to the equipment actually available on the day of the shoot at our partners’ facilities.

We are working on the basis of the following cases :

– 1. Rack focus on tripod : execute a focus switch between two distant markers, a fast (2s) and a slow (1s) version, to test sampling dynamics.

– 2. Variable Focal length (for zooms) on tripod : perform a focal length changeover between two distant markers, a fast version (2s) and a slow version (10s), to test sampling dynamics.

– 3. Variable aperture on tripod : perform an aperture change, a fast version (2s) and a slow version (10s), to test sampling dynamics.

– 4. Focus pull and handheld camera : perform a range shot with lateral movement to create parallax. Combine with panning to frame all the 7 markers. The focus puller will lock onto the depth of the middle row.

– 5 Change of focal length (zoom) plus rack focus with a handheld camera : execute a range shot with lateral movement to create parallax and switch focal length. Combine with panning to frame all markers. The focus puller will target the middle row.

LDS, /i and eXtended

These three names refer to optical metadata technologies :

– LDS is the name of the Lens Data System designed by Arri

– /i is the protocol designed by Cooke

– eXtended Data, derived from /i, is the protocol developed by Zeiss

In concrete terms, the 3 systems extract key data useful for post-production, and by extension for VFX. Some of this data is easily readable in post-production editing or color-grading software, while others are more specific and less accessible.

The basic data are :

– Name, type and focal length of lens used

– Focus distance

– Aperture

– Depth of field

– Hyperfocal distance

The /i2 protocol adds gyro metadata and the /i3 adds shading and deformation metadata (up to 285 fps).

The eXtended Data protocol adds deformation data as well as shading data based precisely on aperture focal length and focus distance.

The LDS-2 is announced as having a higher data rate than the LDS-1, enabling greater precision at high frame rates (for slow-motion shots, for example). Arri is also opening up the use of the LDS-2 protocol to other manufacturers.

Cameras, optics and dedicated devices

For our choice of camera bodies and optics, we’ve endeavored to determine classic shooting configurations, the idea being to integrate modern optics equipped with metadata as well as vintage optics.

For our first workshop, on February 23, 2023, we have a Sony Venice 2, an Arri Alexa 35 and even a Phantom Flex. On the optics side, we’ll be using Zeiss Supreme Primes, Cooke SF+FF and Zeiss Compact Zooms.

As well as two essential little devices : an Arri UMC-4 (Universal Motor Controller) and Ambient’s ACN-LP Lockit+.

To be effective in our case, the Arri UMC-4 allows metadata to be retrieved via the connection with the FIZ motors (Focus, Iris, Zoom) and recorded on an SD card. To correctly interpret the metadata it receives, the UMC-4 must be loaded with a LDA (Lens Data Archive), a file enabling each lens listed (by brand, model, focal length) to be recognized by the camera, so that the metadata sent by the lens is correctly translated and written to the right place in the file for use in post-production.

The Lockit+ not only feeds timecode to the camera (and UMC-4), but also retrieves metadata directly from the lens if it is plugged with a Lemo cable (as is the case with /i and eXtended lenses).

It should be remembered here that, depending on the brand and model, optical metadata passes either through the PL mount contacts or through a specific Lemo socket, and sometimes both ways. However, it would be necessary to determine whether the same information passes through the mount and the Lemo socket – bearing in mind that in the case of the mount, the information is intended to be wrapped into the metadata of image files, and in the case of the Lemo, the information is intended for devices outside the camera body and is stored in sidecar files).

The UMC-4 box is well known to camera assistants, who use optical data to help with focus work : thanks to LDAs, a dedicated device can actually display depths of field calculated using the focal length, aperture and focus point of a given lens.

The ACN LP Lockit+ not only retrieves lens metadata, but also links this data to the timecode. This means you can record which lens settings are made at which times, over the entire duration of the recorded shot. This makes it possible to access the physical data used to produce a given shot. A gold mine for post-production and VFX.

A word of clarification, however : the latest version of Lockit+ only integrates Cooke’s /i3 extended metadata recording. There was talk of Zeiss compatibility in the future, but no certainty yet. Thanks to Yannic Hieber @ambient.de , who kindly entrusted us with a prototype for our work.

This enabled us to record raw data from Cooke lenses with synchronized timecode on SD card in YAML format. For Zeiss configurations, the box simply injected the timecode into the camera and into the electronic slate that was framed. We then had to rely on the cameras’ ability to record metadata via the PL mount.

The challenges for us are severalfold :

The challenges for us are severalfold :

– How to record the metadata generated by the optics for a given camera and series of optics : is this data included in the image files or in other files generated by the cameras ? Can/should this data be retrieved by third-party devices ?

– Identify what equipment we need to record this data : boxes, cables, mounts… And whether our French rental companies are able to supply them !

– Determine which software can display the recorded data and make use of it.

– Affirm the need for a technical dialogue between shooting and post-production to ensure that the metadata generated during shooting is not lost during post-production, given that this metadata is of little interest to editing but is very useful for VFX.

Remember that we’re focusing on shooting conditions outside the virtual studio.

First contacts

We first connect a Venice 2 equipped with a 32mm Cooke SF-FF series, with the following settings : X-OCN XT, 8.6K – 3:2 with 1.8x anamorphic de-Squeeze, shutter at 90.0°, project frame rate @25fps.

We chose a 90° shutter to avoid excessive motion blur. This shutter speed is often recommended to facilitate the integration of VFX when using green and blue screens, the motion blur being added later to make the rendering of movement more natural to the eye.

The set and the positioning of the trackers in relation to the camera are measured by hand and also scanned in 3D with photogrammetry software (here Polycam, on iPad or iPhone), the idea being to ensure that the distances recorded by the metadata are in line with actual distance measurements.

A round object is positioned at the boundary of the frame to monitor any distortion and potentially calculate a precise distortion coefficient.

We plug in the Lockit+, the red cable sends the TC to the cam, the blue cable recovers the optical data sent by the optics.

Once our computer is connected via wifi to the Lockit+ box, the data are displayed, enabling us to record each shot and all the metadata transmitted by the optics. The data are recorded by the box in a text file is in YAML format (between XML and CSV), as plain text (open source), but it’s raw data. We’ll then need to find the software that can parse this data and merge it with the metadata of an image file, based on the timecode and on the classic data describing the shot (name, date, band number, etc.).

We then switched to a Zeiss Supreme Prime 15mm, adapting the camera settings as we went spherical. However, we keep the shutter at 90°. We load the LDA into the UMC-4 and record the metadata from the motors, to be compared with the metadata recorded via the Lockit+ box.

Note that with the Venice 2, we have to manually trigger the recording on the UMC-4.

To get an initial idea of the fruits of our efforts, we compare the metadata actually recorded with the same rush from the Venice.

With Sony’s Raw Viewer software, we can see the type of lens, the sensor, the f-stop and the focus distance in meters, but this is a fixed point (at the very beginning of the shot ?), with no dynamic data (i.e. no changes over the duration of the shot).

In DaVinci Resolve, you need to dig a little deeper !

With Lockit+, the columns are labelled as follows : Lens general, Lens shading, Gyro, Focus distance, Hyper focal, Min distance, Max distance. Depending on the focal length, we could also add vignetting and distortion data.

We then switch to a Zeiss 15-30mm Compact Zoom, to add dynamic data to the focal length values, which are displayed like the other values in real time on the Lockit+ box. The Lockit is not compatible with Zeiss.

We decided to switch to Alexa Mini LF (4.5K recording) with the 32mm Cooke SF+FF, then the 50mm Zeiss Supreme Prime. Data is still transmitted via the Lemo cable to the Lockit+ box.

Switching to Arri means that data recording on the UMC-4’s SD card starts automatically as soon as recording is initiated on the Mini LF (auto trigger). This is a pleasant surprise, as it’s much more comfortable.

To round off the day, and because the camera is right in front of us, we put the 32mm Cooke SF+FF on the Phantom Flex. The camera is rather rudimentary, and a problem soon arises : how do you inject timecode into a time base of 1000 frames per second? And what’s the point of writing FIZ data to an SD card if no timecode synchronizes the camera simultaneously with the UMC-4 box ?

We’re sure there could be further tests, but that would be another chapter, too specific for the purpose of our current work.

In a forthcoming article, we’ll see how LD can be generated with the use of non smart lenses. To be continued !

Thanks to Valentine Lequet, co-president of UCO, Sara Cornu, Larry Rochefort and Teddy Ajolet, camera assistant. Many thanks to the PhotoCineRent team for their warm welcome and involvement.

-

Partager l'article